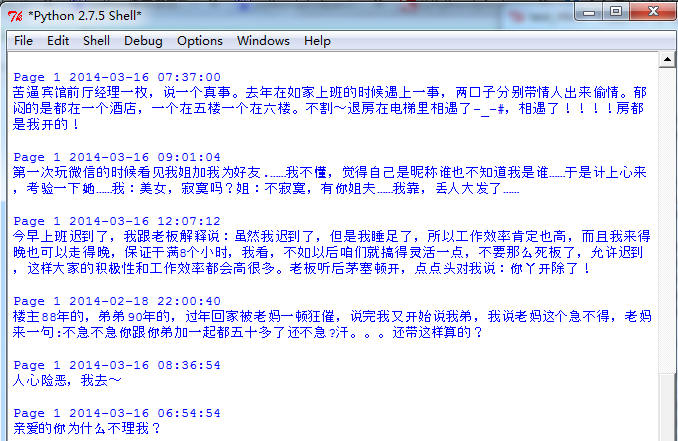

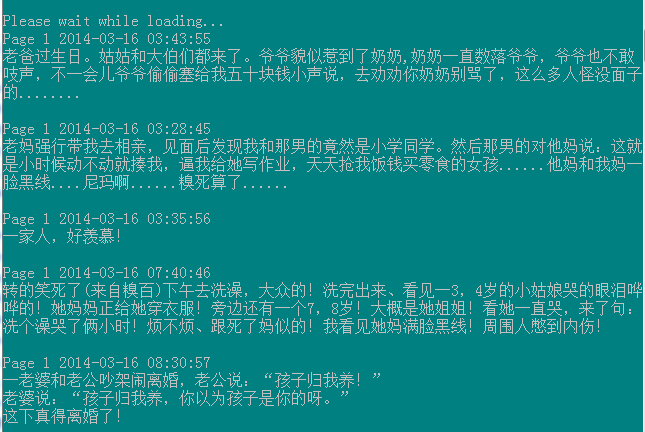

可以直接运行的代码,在http://down.51cto.com/data/1102905,感兴趣可以来尝试看看,以下是一个最简单的直接抓取整个糗事百科的所有源代码的demo,提供下载的版本已经使用正则表达式做过了精细的处理,效果如上图。

# python 2.7.5

import urllib2

myUrl = "http://m.qiushibaike.com/hot/page/"

headers = ('User-Agent','Mozilla/5.0 (Windows NT 6.1) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/29.0.1547.66 Safari/537.36 LBBROWSER')

opener = urllib2.build_opener()

opener.addheaders = [headers]

data = opener.open(myUrl).read()

print data

相关推荐

python爬虫,爬取糗事百科python爬虫,爬取糗事百科python爬虫,爬取糗事百科python爬虫,爬取糗事百科python爬虫,爬取糗事百科python爬虫,爬取糗事百科python爬虫,爬取糗事百科python爬虫,爬取糗事百科python...

糗事百科的爬虫,是主要用来介绍爬虫的一些基本知识,方便大家爬取简单的糗事百科的内容,利用的是beautifulsoup

python爬虫入门实例,基于python3.6,实现糗事百科段子逐条读取,按回车键继续下一条,供python爬虫初学者参考学习!----2017.9.12

python爬取糗事百科源码

获取糗事百科段子程序,拥有UI交互界面 下载之后无需任何配置,可以直接运行 具体的程序请参考:http://blog.csdn.net/qiqiyingse/article/details/64522690

python糗事百科数据爬虫.zip

简单的糗事百科爬虫代码,用几十行代码即可实现爬取糗事百科首页内容。

亲测有效,不管是windows 还是Linux都...使用python 爬取糗事百科的段子,通过回车键控制,一次一个,同时可以把看过的内容保存到本地查看 具体实现可以参照 http://blog.csdn.net/qiqiyingse/article/details/60583129

python程序用于自动获取糗事百科的内容

【爬虫脚本】糗事百科爬虫之一 用python语言编写,只是转发,希望pythoner共勉

糗事百科爬虫文件.py

【爬虫】糗事百科爬虫之二 urllib2的应用脚本,希望pythoner共勉

本文是结合前面的三篇关于python制作爬虫的基础文章,给大家分享的一份爬取糗事百科的小段子的源码,有需要的小伙伴可以参考下

使用Python3.6抓取糗百、不得姐、kanqu.com数据,完整代码可运行,内附使用说明(main.py),及运行演示(demo.gif).

程序:糗百爬虫 版本:0.3 作者:欧小帅 日期:2016-04-03 语言:Python 2.7 操作:输入quit退出阅读糗事百科 功能:按下回车依次浏览今日的糗百热点

关于python的爬虫,爬的主要是糗事百科的图片,后续会有更多的操作

通过scrapy框架获取页面内容,用beautifulsoup取代正则表达式匹配格式,获取多页段子

请求网页: 爬虫使用HTTP或其他协议向目标URL发起请求,获取网页的HTML内容。这通常通过HTTP请求库实现,如Python中的Requests库。 解析内容: 爬虫对获取的HTML进行解析,提取有用的信息。常用的解析工具有正则...

刚学没多久的python实战,最终选定的是糗事百科网站,爬取前13页的内容(可更改),具体效果图可以看我发的贴子教程,欢迎大家来讨论经验